大家有没有发现很多时候我们在robots文件中添加了禁止抓取的内容,但是还是被正常的收录了,这个就比较气人了有的人是不管怎么折腾就是不收录,有的人禁止抓取的内容尽然还在收录,没有对比就没有伤害!

那么为什么明明已经设正确设置的robots的屏蔽规则,但是就是不生效导致不该收录的内容被收录了呢?

robots更新周期

造成这一问题主要的原因,潘某人SEO认为主要还是在于robots的更新周期,搜索引擎每次抓取网站的内容的时候并不会每次都抓取下robots文件,因此很多时候站点更新了robots文件的规则了,但是搜索引擎并没有抓取最新的robots规则,还是会按照之前的规则进行抓取。

如何避免

首先网站搭建的时候就应该做好结构的规划,在网站上线的时候就应该完成robots文件的配置,避免后期去调整,是最有效的方法。但是在实际情况中很少有站点可以做到这一点,那么在robots文件规则发生变化的时候,要避免不该收录的内容被继续收录的问题,就需要及时通知搜索引擎站点更新了robots文件。

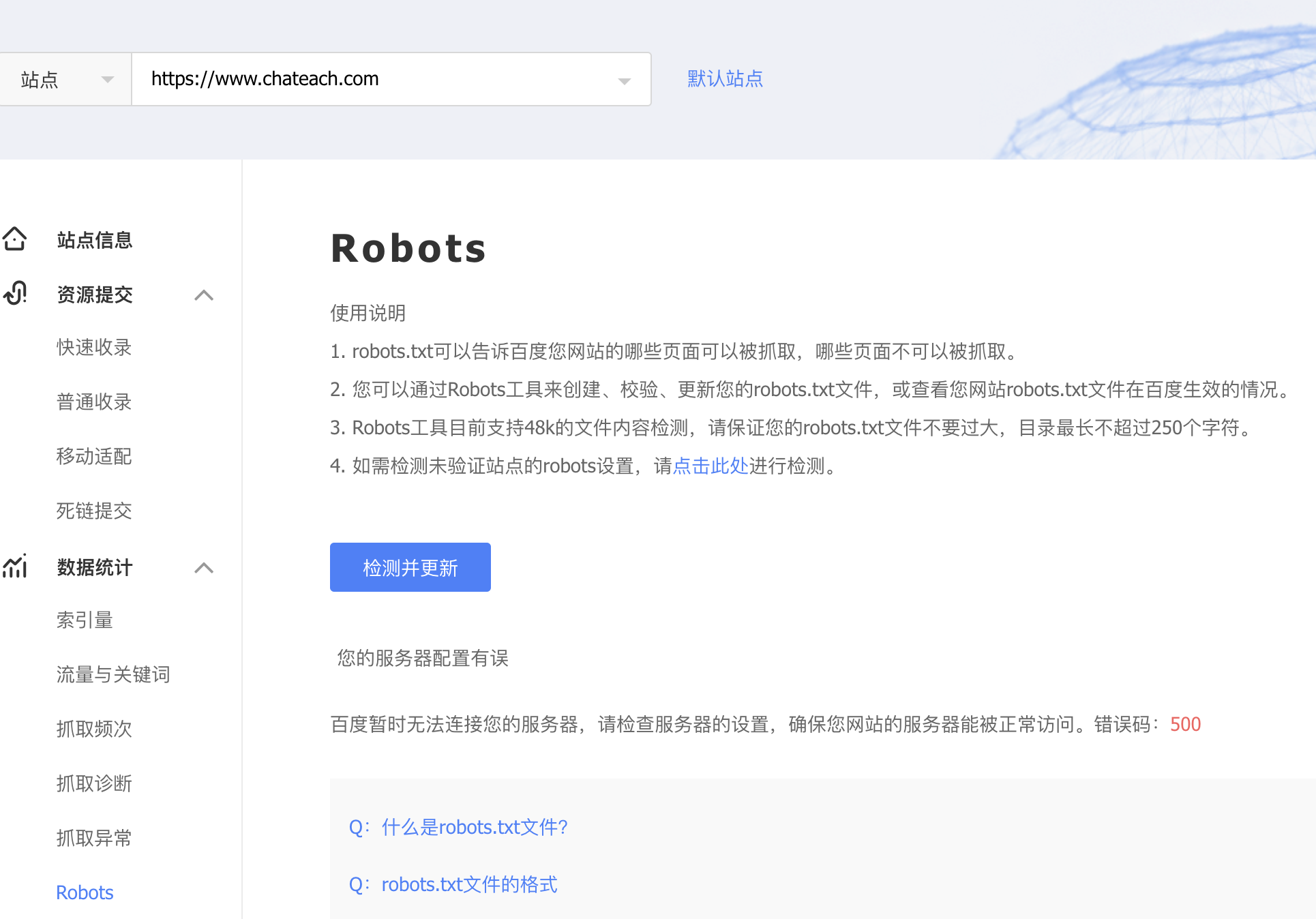

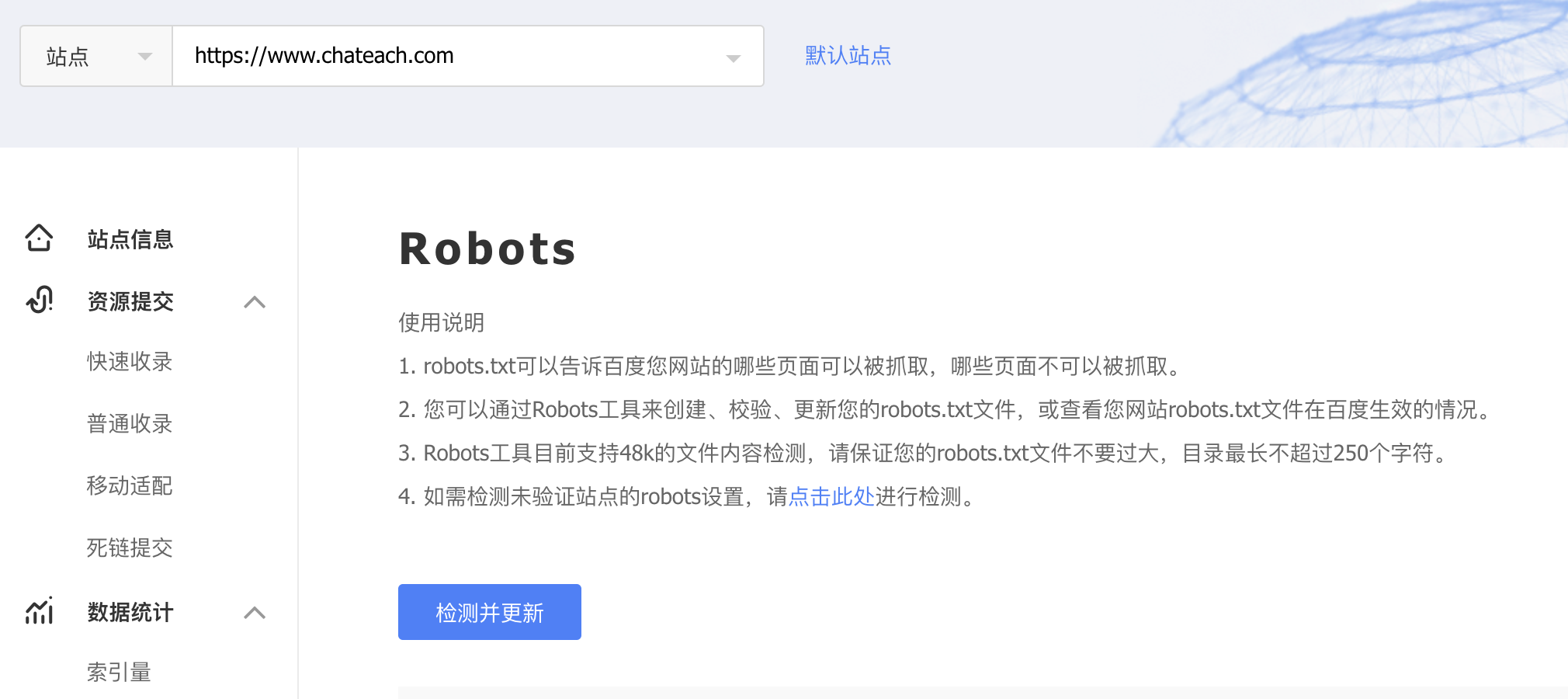

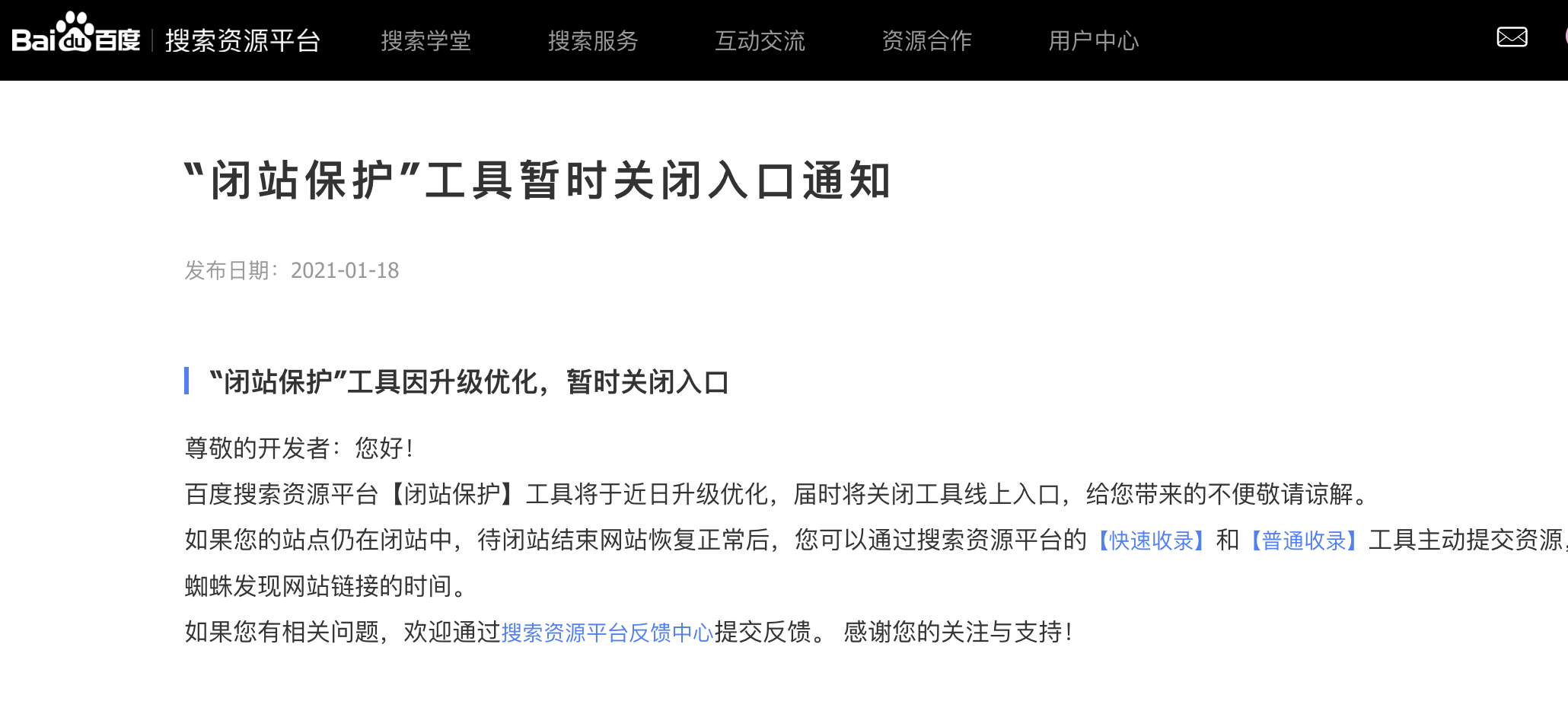

以百度搜索引擎为例子,百度搜索资源平台为站长们提供了相关的robots更新工具,在robots文件更新之后,可以前往这个工具进行更新,从而加快搜索引擎发现robots更新周期,如下图所示。

已收录内容如何处理

即使我们已经进行了robots规则更新,但是已经收录的内容,虽然在robots文件中进行了屏蔽,但是这些已收录的内容往往需要很长一段时间才会消失,甚至有可能长期不消失。

其实当我们最新版本的robots文件生效之后,新收录的内容会规则当前规则进行;但是已经收录的内容并不会马上消失,而是要等待之后的再次抓取的时候才会生效。然而不同的站点的已收录内容的抓取周期上的差距会很大,即使是同一个站点,不同内容的抓取更新周期也不一样。

如何加快已收录内容的删除

有时候一些已经被收录的内容,需要快速的让搜索引擎删除收录,仅仅靠robots文件进行屏蔽是做不到的。潘某人SEO在此分享一个简单高效的方法,那就是死链接提交。将误收录的页面状态码设为404,但如果页面仅仅只是不想被搜索引擎收录,但是还是允许被用户访问。

那么这个时候就不可以简单粗暴使用404页面,这个时候就可以通过后端根据客户端的user-agent判断当前访问如果是属于搜索引擎则返回404页面,其它的访问者则正常的访问。然后在搜索引擎提交死链,会比你单纯的等待robots文件生效的效果高很多。

相关文章

-

robots文件有什么用

robots文件作用对于SEO优化不可忽视给i,可以有效提高网站内容的质量减少重复收录,保护隐私数据不被抓取!

-

robots文件里该不该加上sitemap地址

robots文件里该不该加上sitemap地址,有种说法就是搜索引擎抓取一个网站首先会抓取robots文件,这样把sitemap地址写在robots文件里,这样搜索引擎可以地址直接的对网站地图进行抓取,可以加快链接收录的速度,真相并不是这样

-

巧用robots避免蜘蛛黑洞

今天我们来了解下什么是蜘蛛黑洞,黑洞大家应该有一定的了解,属于一种高质量高引力天体,包括光任何的物体都无法逃逸。蜘蛛黑洞既是蜘蛛进入之后无法再出来,对正常的抓取工作产生负面影响。

-

SEO优化必须掌握的robots文件协议

robots文件使用来申明网站哪些内容允许搜索引擎抓取,哪些内容禁止搜索引抓取的;正确的设置robots可以提升搜索引擎对网站的抓取效率,同时避免不必要的内容被抓取展现。但在实际运用中很多站点没有正确的使用robots导致了一些问题,今天潘某人SEO就为大家揭秘下robots的注意点。

-

巧用Robots避免蜘蛛黑洞

搜索引擎的蜘蛛黑洞指的是搜索引擎蜘蛛在抓取站点内容的时候出现了大量雷同内容的url,导致搜索引擎蜘蛛一直被困在无限的循环中,如黑洞一般。直接的结果就会导致消耗大量的抓取资源。

-

如何屏蔽某些页面的抓取,但是让页面中链接正常抓取

如何屏蔽某些页面的抓取,但是让页面中链接正常抓取,对于这种情况,使用meta标签来进行屏蔽页面的抓取,可以变得更加的有效。相比常用的robots文件屏蔽,或者nofollow标签屏蔽的实用性更加的广。

-

seo标题写法及其重要性

标题对于SEO优化起着一个什么样的作用呢,这是一个值得思考的问题。很多人认为一个好的标题对于排名有着很好的作用,但是个人不这么认为,标题的作用没有我们想象的那么重要!

-

搜索引擎对于AI生成内容的态度

随着生成式AI技术的普及,大量网站开始采用人工智能批量生产内容以提升运营效率,AI工具能够高效产出大量文本、图片甚至视频,帮助站点快速填充版面、覆盖长尾关键词,其多语言能力和数据驱动的优化策略也为SEO带来了新机遇,AI生成内容只要满足E-E-A-T原则(专业性、经验性、权威性、可信度),即可获得正常排名。

-

site首页位置不在第一怎么办

很多站长在网站优化的时候会特别的关注网站site首页的排名位置,当首页不在第一位的时候就会非常的不安,觉得网站出现了问题,认为站点被降权了。但是网站site首页不在首位很多原因都会造成这种结果。

-

什么是闭站保护,无法申请闭站保护怎么办?

闭站保护是什么,闭站保护对于站点有什么作用;但是如果站点无法申请闭站保护又要如何应对呢?今天潘某人SEO就以一次闭站的经历分享来告诉大家如何正常的处理闭站保护。

-

如何看网站日志对于seo优化的重要性

如何看网站日志对于seo优化的重要性!可以及时的发现网络攻击,以及采集行为;可以更好保护站点的安全性,更加有利于网站的seo优化。

-

如何快速提升关键词排名?

如何快速提升关键词排名?可以从流量冲击、时效性热点内容 、高质量外链、网站整体权重、交换一些友情链接,多角度同时进行有效快速提升关键词排名。

-

求职避雷指南:连SSL证书都要省的公司,你敢去吗?

今天这篇文章不仅仅适用于SEO优化从业者,同时也适用于其他岗位的求职者,那你从此刻起,多了一个更加靠谱的方法判断公司是否靠谱。

-

多域名解析到同一网站利于排名吗?

多域名解析到同一个网站,个人觉得这种行为就是闲的,没事找事给自己挖坑。多域名解析到同一个网站,首先运营上的意义不大,并且非常容易出现重复收录,权重分散的问题,所以除非有迫不得已的原因,打死都不要去多域名解析到一个网站。

-

手机网站的优化注意事项

随着智能手机的崛起,移动互联网的占比越来越高,对于部门行业领域移动端已经吊打PC端,比如电商类的站点,大部门的成交都是在移动端完成的。因此,现在开始必须注重移动手机站点的优化。

-

什么是链接农场,及其对于网站的危害

链接农场对于网站优化的威胁超级大,不但自己不该做,有的时候防不甚防一不小心掉进链接农场,很多时候很多站点做着做着不知不觉就变成链接农场了

-

百度搜索引擎优先建重要库的原则

Baiduspider抓了多少页面并不是最重要的,重要的是有多少页面被建索引库,即我们常说的“建库”。众所周知,搜索引擎的索引库是分层级的,优质的网页会被分配到重要索引库,普通网页会待在普通库,再差一些的网页会被分配到低级库去当补充材料。目前60%的检索需求只调用重要索引库即可满足,这也就解释了为什么有些网站的收录量超高流量却一直不理想。

-

百度自然搜索排序规则

搜索引擎排名规则应该是广大站点探究的话题,只有对各大搜索引擎的排名规则有所了解,才能更有针对性的做优化,最短时间获得最好的效果。那么那些因素是决定排名的主要的因素,分享下个人的理解。