Sitemap(站点地图)本身是一个强大的工具。它以结构化的XML格式,清晰地列出网站上希望搜索引擎索引的所有重要页面链接。对于大型、结构复杂或新上线的网站,提交Sitemap能显著帮助搜索引擎更快地发现站点的内容。

然而,任何工具都有其两面性。Sitemap这把“钥匙”,既能打开搜索引擎友好抓取的大门,也可能为不速之客大开方便之门。

致命误区

将Sitemap暴露在robots.txt,这是潘某人SEO认为最致命的sitemap的使用方式,许多站长(甚至一些SEO教程)会建议在robots.txt文件中网站地图的链接。逻辑是:“搜索引擎抓取网站的第一步会抓取站点的robots.txt,可以更快找到并抓取所有页面,提升收录效率。”

残酷的现实是:robots.txt文件是公开可读的!任何访问你网站的网络爬虫(无论好坏),这会让你的站点面临巨大的风险。这无异于:你为了方便快递员送货,把家里的详细住址和所有房间的钥匙,贴在了小区公告栏上。结果,不仅快递员来了,小偷、推销员、骚扰者也全都知道了你的家在哪里,甚至知道你家客厅有电视、卧室有保险柜。

暴露sitemap的风险

将sitemap通过robots.txt公开,会带来一系列严重后果:最直接的风险,你的所有页面都一览无余,黑产爬虫会利用这份清单,进行大规模、高频率的针对性爬取,消耗你的服务器带宽和资源,可能导致网站变慢甚至宕机。

内容盗用风险飙升:内容搬运工、采集站能轻易获取你所有文章的URL,进行自动化复制、洗稿,窃取你的原创成果。竞争对手可以轻松获取你的内容结构和重点页面,分析你的策略。

安全的基本原则之一是“最小权限”和“最小暴露”。潘某人SEO认为让链接难以被发现,是成本最低、最有效的防爬的方法。

sitemap的正确打开方式

不仅仅不能再robots.txt暴露sitemap的地址,在其它的任何的地方都不应该被暴露,同时sitemap的路径不能常规化,是使用难以被猜测的路径,可以最大程度保护站点内容。

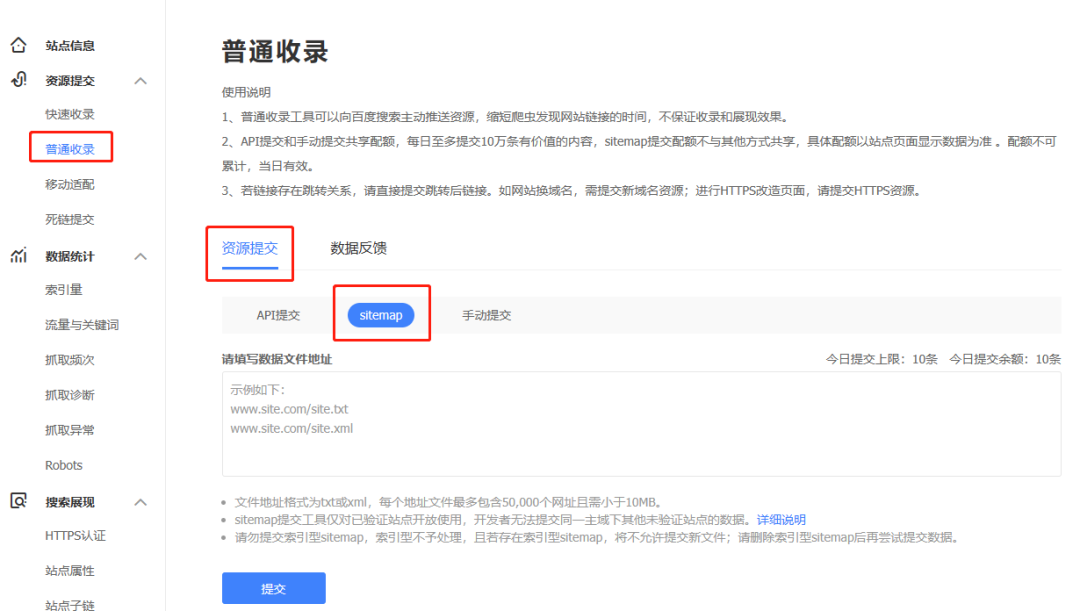

sitemap只应该通过搜索引擎后台直接提交,不应该出现在任何地方。除了Sitemap,其他内部链接结构也应遵循此原则。避免在公开页面上列出所有文章的索引页,依赖搜索引擎的自然发现机制(通过站内链接跳转)来抓取大部分页面,而非一次性暴露所有。

结语

SEO优化不应以牺牲网站安全为代价。将Sitemap提交到 robots.txt是一个典型的“好心办坏事”的案例。它看似能提升抓取效率,但实际中对于抓取并没有多大的作用,反而将网站置于不必要的风险之中。

结语言

Sitemap是给搜索引擎的“内部通讯录”,不是贴在墙上的“公众公告”。最有效的防护,往往始于“不主动暴露”。优先使用搜索引擎站长工具提交Sitemap,这才是安全、高效、可控的正确之道。